10月19日大模型日報合輯

【10月19日大模型日報合輯】Transformer一作來卷多模態! 學術圖表也能看懂,100毫秒極速響應|免費試玩;OpenAI新模型研發遇挫,稀疏性是大模型降本的鑰匙嗎;OpenAI圖像檢測工具曝光,CTO:AI生成的99%都能認出

Transformer一作來捲多模態! 學術圖表也能看懂,100毫秒極速響應|免費試玩

連結:https://news.miracleplus.com/share_link/11024

Transformer一作攜團隊也帶來了新作,一個規模為80億參數的多模態大模型Fuyu-8B。 而且發布即開源,模型權重在Hugging Face上可以看到。 此模型具備強大的圖像理解能力。 照片、圖表、PDF、介面UI都不在話下。 能從一張複雜的食物網裡理清楚各個生物之間的關係。

OpenAI新模型研發遇挫,稀疏性是大模型降本的鑰匙嗎?

連結:https://news.miracleplus.com/share_link/11025

去年年底,當 ChatGPT 引起全球轟動時,OpenAI 的工程師開始研究一種新的人工智慧模型,代號為 Arrakis。 Arrakis 旨在讓 OpenAI 能夠以更低的成本運行聊天機器人。 但據知情人士透露:2023 年年中,OpenAI 已經取消了 Arrakis 的發布,因為該車型的運作效率沒有公司預期的那麼高。 這次失敗意味著 OpenAI 失去了寶貴的時間,並需要將資源轉移到開發不同的模型上。 對合作投資來說,Arrakis 的研發計畫對於兩家公司完成 100 億美元投資和產品交易的談判非常有價值。 根據一位知情的微軟員工透露,Arrakis 的失敗讓微軟的一些高階主管感到失望。 更重要的是,Arrakis 的失敗預示著人工智慧的未來發展可能充滿難以預測的陷阱。

OpenAI影像偵測工具曝光,CTO:AI生成的99%都能認出

連結:https://news.miracleplus.com/share_link/11026

OpenAI要出手AI影像辨識了。 最新消息,他們公司正在開發一種檢測工具。 根據技術長Mira Murat透露:此工具精度非常高,正確率可達99%。 目前已進入內部測試流程中,很快就會公開發布。 不得不說,這個準確率還是讓人有點期待的,畢竟之前OpenAI在AI文本檢測上的努力可是以「26%的正確率」慘敗告終。

微軟Azure OpenAI支援資料微調囉! 可打造專屬ChatGPT

連結:https://news.miracleplus.com/share_link/11027

10月17日,微軟在官網宣布,現在可以在Azure OpenAI公共預覽版中對GPT-3.5-Turbo、Babbage-002 和Davinci-002模型進行資料微調。 使得開發者透過自己的資料集,便能打造獨一無二的ChatGPT。 例如,透過大量醫療資料微調,建構專注醫療領域的ChatGPT助手,可詢問與醫療相關的病歷、專業術語、治療方案等內容。 目前,全球各產業累積了幾年甚至幾十年的巨量優質數據,如何有效利用、查詢這些數據成為一大難題。 透過自有資料微調打造的AI助理可有效解決此痛點,同時提升內容的準確性、安全性,是組織實現降本增效的利器。

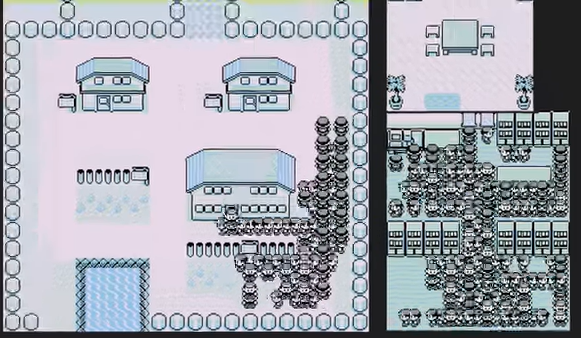

狂攬4k star,AI透過強化學習玩寶可夢,兩萬場後成功拿下

連結:https://news.miracleplus.com/share_link/11028

「寶可夢」是「寶可夢」的非官方譯本。 從 1996 年至今,它可以分成數個世代,成為許多玩家心中的經典。 遊戲畫風簡單,但是身為策略遊戲,其中包含的角色、屬性、戰術、體係等讓這個遊戲入門容易精通難。 如果訓練 AI 來玩寶可夢,你覺得它的實力如何? 推特用戶 @computerender 用強化學習訓練 AI 玩起了寶可夢。 他也透過影片記錄了這個過程,不僅生動地展示了訓練過程,還詳盡地介紹了其中的方法。

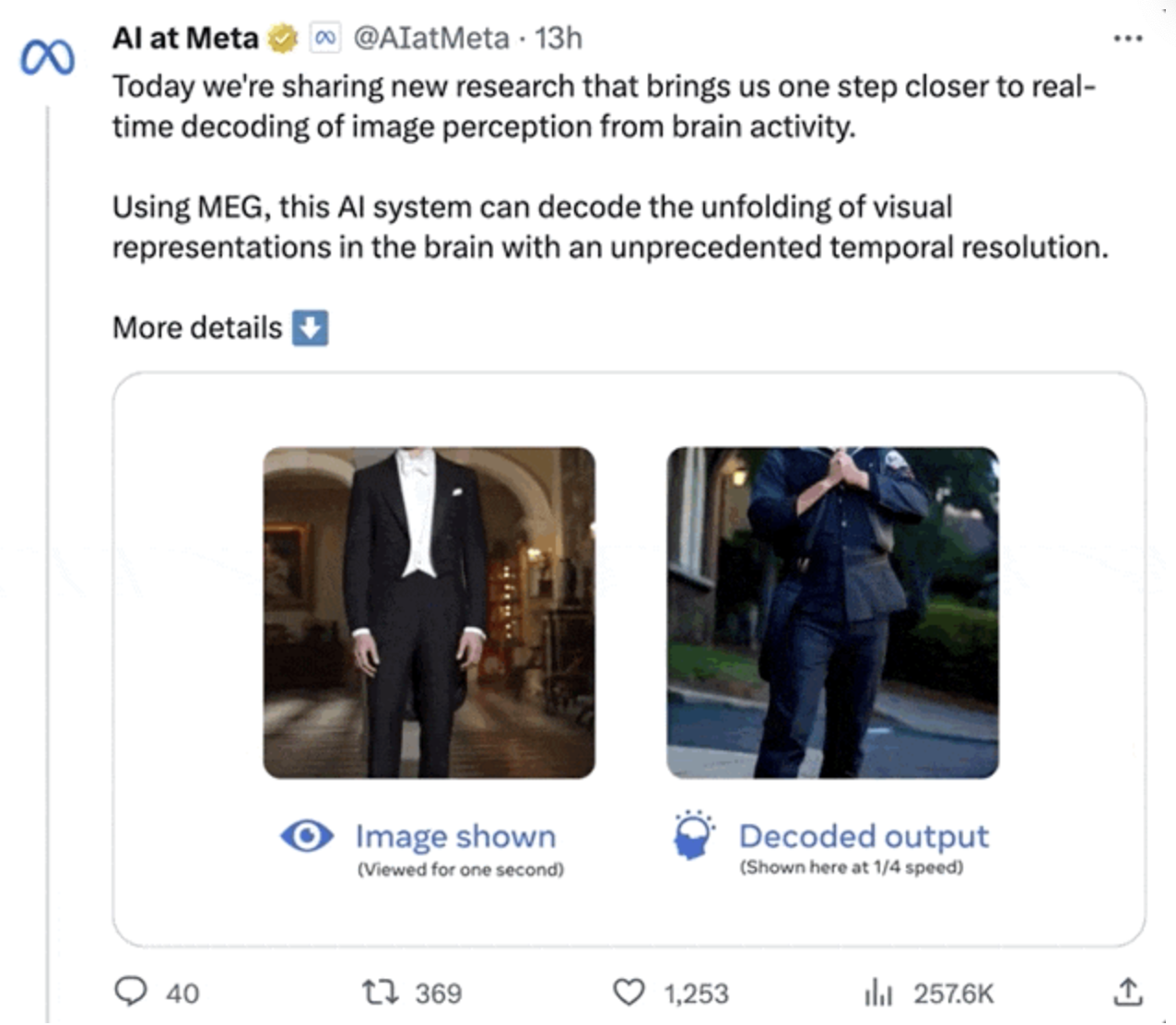

AI即時解讀大腦訊號,7倍速還原影像關鍵視覺特徵,LeCun轉發

連結:https://news.miracleplus.com/share_link/11029

現在,AI已經能即時解讀大腦訊號了。 這不是聳人聽聞,而是Meta的新研究,能夠憑腦訊號猜出你在0.5秒內看的圖,並用AI即時還原出來。 在此之前,AI雖然已經能從大腦訊號中比較準確地還原影像,但還有個bug-不夠快。 為此,Meta研發了一個新解碼模型,讓AI光是影像檢索的速度就提升了7倍,幾乎「瞬間」能讀出人在看什麼,並猜出個大概。

全都不及格! 史丹佛100頁論文給大模型透明度排名,GPT-4僅排第三

連結:https://news.miracleplus.com/share_link/11030

試問百模大戰的當下,誰家大模型的透明度最高? 例如模型是如何建構的、如何運作、使用者如何使用它們的相關資訊。 現在,這個問題終於有解了。 因為史丹佛大學HAI等研究機構最新共同發布了一項研究-專門設計了一個名為基礎模型透明度指標(The Foundation Model Transparency Index)的評分系統。 它從100個維度對國外10家主流的大模型做了排名,並在透明度這一層面上做了全面的評估。

大模型總弄錯「事實」怎麼辦? 這有一份匯集了300多篇文獻的綜述

連結:https://news.miracleplus.com/share_link/11031

大模型在掌握事實性知識上展現出巨大的能力和潛力,但是其仍然存在一些問題,比如缺乏領域知識,缺乏實時知識,可能會產生幻覺等等,這極大的限制了大模型的應用和 可依靠性。 近期已經有一些工作針對大模型的事實性進行了研究,但仍未有文章對大模型事實性的定義、影響、評估、分析和增強進行完整的梳理。 西湖大學聯合國內外十家科研單位發表了一篇大模型事實性的綜述《Survey on Factuality in Large Language Models: Knowledge, Retrieval and Domain-Specificity》,該綜述研究了三百餘篇文獻,重點討論了事實 性的定義和影響、大模型事實性的評估、大模型事實性機制和產生錯誤的原理、大模型事實性的增強等幾個方面的內容,對大模型的事實性進行了詳細的梳理和總結 。 這篇綜述的目標是為了幫助學界和業界的研究開發人員更好得理解大模型的事實性,增加模型的知識水準和可靠性。

IDC:到2027年,全球生成式AI支出將達到1,430億美元

連結:https://news.miracleplus.com/share_link/11032

全球著名資訊調查諮詢機構IDC在官網公佈了一項調查,到2027年,全球生成式AI(Generative AI,簡稱Gen AI)支出將達到1430億美元,5年複合年增長率為73.3%。 此支出包括:生成式AI的軟體以及相關基礎設施硬體和 IT /商業服務等。 2023年,全球企業在 生成式AI解決方案的投資近160億美元。 IDC表示,2023-2027年的複合年增長率 (CAGR) 為 73.3%。 這是整體人工智慧支出成長率的2倍多,幾乎是同期全球IT支出複合年增長率的13倍。