お正月まとめ(12月30日~1月1日)大型モデル日替わりコレクション

【お正月まとめ(12月30日~1月1日)大型モデル日替わりコレクション】AI描画モデルが書けない問題はアリババで解決、基本モデル+ロボットは今どこにあるのか、大型言語モデルの生物学的推論をテストGPT-4、PaLM2などの能力がすべてテストされます

GPT-4が愚かである理由を新たに説明します

かつては世界で最も強力だと考えられていた GPT-4 も、そのリリース以来、何度も「自信の危機」を経験しました。 今年初めの「断続的な知能低下」が OpenAI による GPT-4 アーキテクチャの再設計に関連しているのであれば、少し前の「怠け者になった」という噂はさらにおかしなことになる。冬休み」になると、まるで冬眠状態に入ったかのように怠惰になってしまいます。 大規模なモデルは怠惰で愚かになります。これは具体的には、新しいタスクに対するモデルのゼロサンプルのパフォーマンスが悪化することを意味します。 上記の理由は興味深いように思えますが、問題は具体的にどのように解決されるのでしょうか? 最近の論文で、カリフォルニア大学サンタクルーズ校の研究者は、GPT-4 のパフォーマンス低下の根本的な理由を説明する可能性のある新しい発見を発見しました。

Mamba は Transformer の代わりに使用できますが、組み合わせることもできます

リンク: https://news.miracleplus.com/share_link/14737

Transformer は優れていますが、特に長いシーケンスの処理に関しては完璧ではありません。 状態空間モデル (SSM) は、長いシーケンスに対して非常に優れたパフォーマンスを発揮します。 研究者らは昨年の時点で、SSM を Transformer の代わりに使用できると提案しました。 しかし実際には、SSM と Transformer はどちらか一方を選択するアーキテクチャではなく、完全に組み合わせることができます。 最近発表された NeurIPS 2023 の論文「Block-State Transformers」ではこのアプローチが採用されており、65k トークン長の超長入力を容易にサポートできるだけでなく、計算効率も非常に高く、ループ ユニットを使用した Transformer と比較して、高速化されています。 10倍も改善できる! この論文は、Mamba の著者である Tri Dao 氏も賞賛し、「SSM と Transformer は相互に補完し合っているようだ」と述べています。

AI描画モデルが書けない問題をアリババが解決

リンク: https://news.miracleplus.com/share_link/14738

漢字を正確に書けるAI描画ツールがついに登場! 中国語を含む計4言語に対応しており、文字の位置を任意に指定できます。 今後、人々はついに AI 描画モデルの「ゴースト描画シンボル」に別れを告げることができます。 AnyText というこの描画ツールは Alibaba から提供されており、指定した位置に従って画像に正確にテキストを追加できます。 以前の描画モデルは一般に、画像にテキストを正確に追加できず、たとえ追加できたとしても、中国語のような複雑な構造のテキストをサポートするのは困難でした。 現在、Anytext は中国語、英語、日本語、韓国語の 4 つの言語をサポートしており、フォントが正確であるだけでなく、スタイルも画像と完全に統合できます。

これまでに見たことのない新しいバージョン、Transformer の数学的原理が明らかに

リンク: https://news.miracleplus.com/share_link/14739

2017 年に Vaswani 氏らによって出版された「attention is all you need」は、ニューラル ネットワーク アーキテクチャの開発における重要なマイルストーンとなりました。 この論文の中心的な貢献はセルフアテンション メカニズムです。これは、トランスフォーマーを従来のアーキテクチャから区別する革新であり、トランスフォーマーの優れた実用的なパフォーマンスにおいて重要な役割を果たします。 実際、このイノベーションは、コンピューター ビジョンや自然言語処理などの分野における人工知能の進歩の重要な触媒となっていると同時に、大規模な言語モデルの出現においても重要な役割を果たしています。 したがって、トランスフォーマー、特に自己注意がデータを処理するメカニズムを理解することは重要ですが、ほとんど研究されていない分野です。

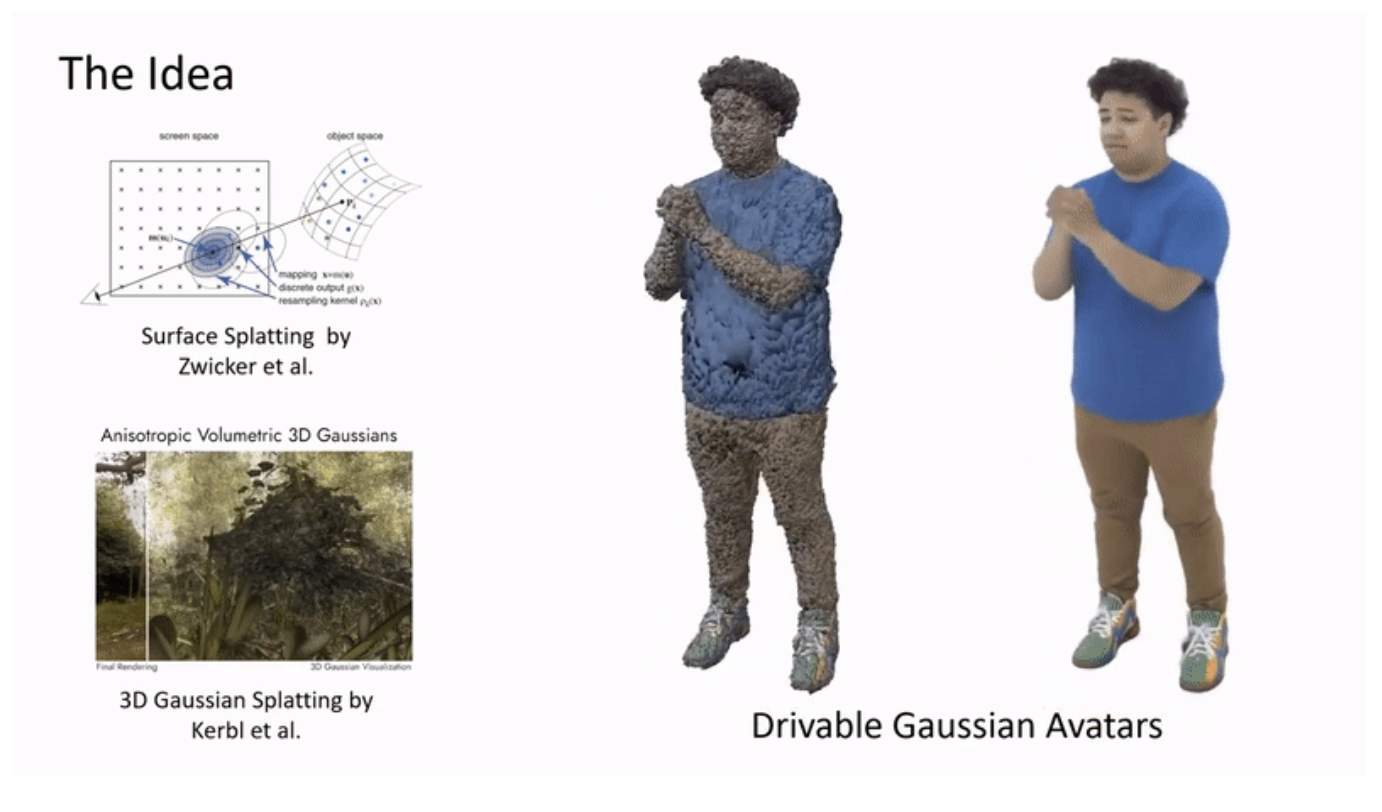

AI研究も印象派から学べるのでしょうか? これらの本物そっくりの人々は実際には 3D モデルです

リンク: https://news.miracleplus.com/share_link/14740

トレーニング中に正確な 3D レジストレーションを必要とするか、テスト中に高密度の入力イメージを必要とする、または場合によってはその両方を必要とする、リアルでダイナミックな仮想キャラクターを作成する場合、おそらく D3GA が良い選択となります。

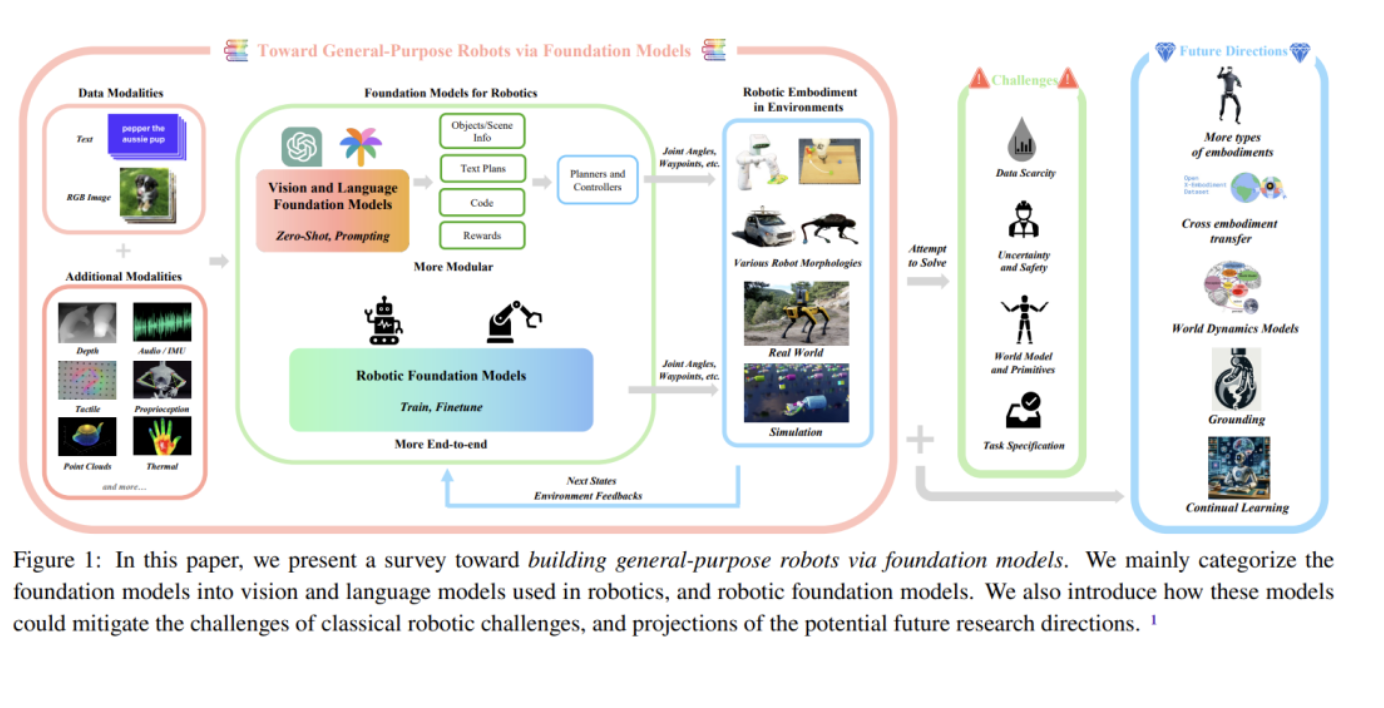

基本モデル + ロボット: 私たちは今どこにいるのでしょうか?

リンク: https://news.miracleplus.com/share_link/14741

ロボットは、特にスマート テクノロジーと組み合わせた場合、無限の可能性を秘めたテクノロジーです。 最近多くの革新的なアプリケーションを作成してきた大型モデルは、ロボットの知的な頭脳となり、ロボットが世界を認識して理解し、意思決定や計画を立てるのを支援すると期待されています。 最近、CMU の Yonatan Bisk 氏と Google DeepMind の Fei Xia 氏が率いる共同チームが、ロボット工学分野における基本モデルの応用と開発を紹介するレビュー レポートを発表しました。

大規模言語モデルの生物学的推論能力をテストします。テストには GPT-4、PaLM2 などが含まれます。

リンク: https://news.miracleplus.com/share_link/14742

大規模言語モデル (LLM) の最近の進歩により、汎用人工知能 (AGI) を生物学の研究と教育に統合する新たな機会が提供されています。 最新の研究では、ジョージア大学とメイヨークリニックの研究者らが、GPT-4、GPT-3.5、PaLM2、Claude2、SenseNovaを含むいくつかの主要なLLMが概念的生物学の疑問に答える能力を評価した。 モデルは、分子生物学、バイオテクノロジー、代謝工学、合成生物学などの生物学的トピックをカバーする 108 問の多肢選択試験でテストされました。 これらのモデルの中で、GPT-4 は最高の平均スコア 90 を達成し、異なるキューを使用した試験全体で最も高い一貫性を示しました。 その結果、GPT-4には論理的推論能力があり、データ分析、仮説生成、知識統合などの機能を通じて生物学研究を支援する可能性があることが示された。 ただし、LLM が生物学的発見を加速するには、さらなる開発と検証がまだ必要です。