10月21日-10月22日大模型日報合集

【10月21日-10月22日大模型日報合集】ChatGPT與DALL·E 3之間的行業「黑話」被發現了;220億晶體管,IBM機器學習專用處理器NorthPole,能效25倍提升; 馬斯克xAI首個研究成果發布! 創始成員楊格&姚班校友共同一作

ChatGPT與DALL·E 3之間的行業「黑話」被發現了

連結:https://news.miracleplus.com/share_link/11082

上個月底,OpenAI 發布了最新影像產生器 DALL·E 3,除了炸裂的生成效果外,最大看點是其與 ChatGPT 的整合。 DALL·E 3 建構在 ChatGPT 之上,用 ChatGPT 來創建、拓展和最佳化 prompt。 這樣一來,用戶無需在 prompt 上花費太多時間。 隨著使用者不斷測試 DALL·E 3 應用程式的功能,有人開始注意到一些非常有趣的 bug,顯示了 DALL·E 3 與 ChatGPT 之間共享的內部提示(prompt)。 令人好奇的是,這些指令中包含了全部大寫以示強調的命令,展示了 AI 之間可能存在類似於人類的溝通技巧。

有了GPT-4之後,機器人把轉筆、盤核桃都學會了

連結:https://news.miracleplus.com/share_link/11083

在學習方面,GPT-4 是一個厲害的學生。 在消化了大量人類數據後,它掌握了各門知識,甚至在聊天中能為數學家陶哲軒帶來啟發。 同時,它也成為了一名優秀的老師,而且不光是教書本知識,還能教機器人轉筆。 這個機器人名叫 Eureka,是來自英偉達、賓州大學、加州理工學院和德州大學奧斯汀分校的研究。 這項研究結合了大型語言模型和強化學習的研究成果:以 GPT-4 來完善獎勵函數,以強化學習來訓練機器人控制器。 借助 GPT-4 編寫程式碼的能力,Eureka 擁有了出色的獎勵函數設計能力,它自主產生的獎勵在 83% 的任務中優於人類專家的獎勵。 這種能力可以讓機器人完成許多之前不容易完成的任務,例如轉筆、打開抽屜和櫃子、拋球接球和盤球、操作剪刀等。 不過,這一切暫時都是在虛擬環境中完成的。

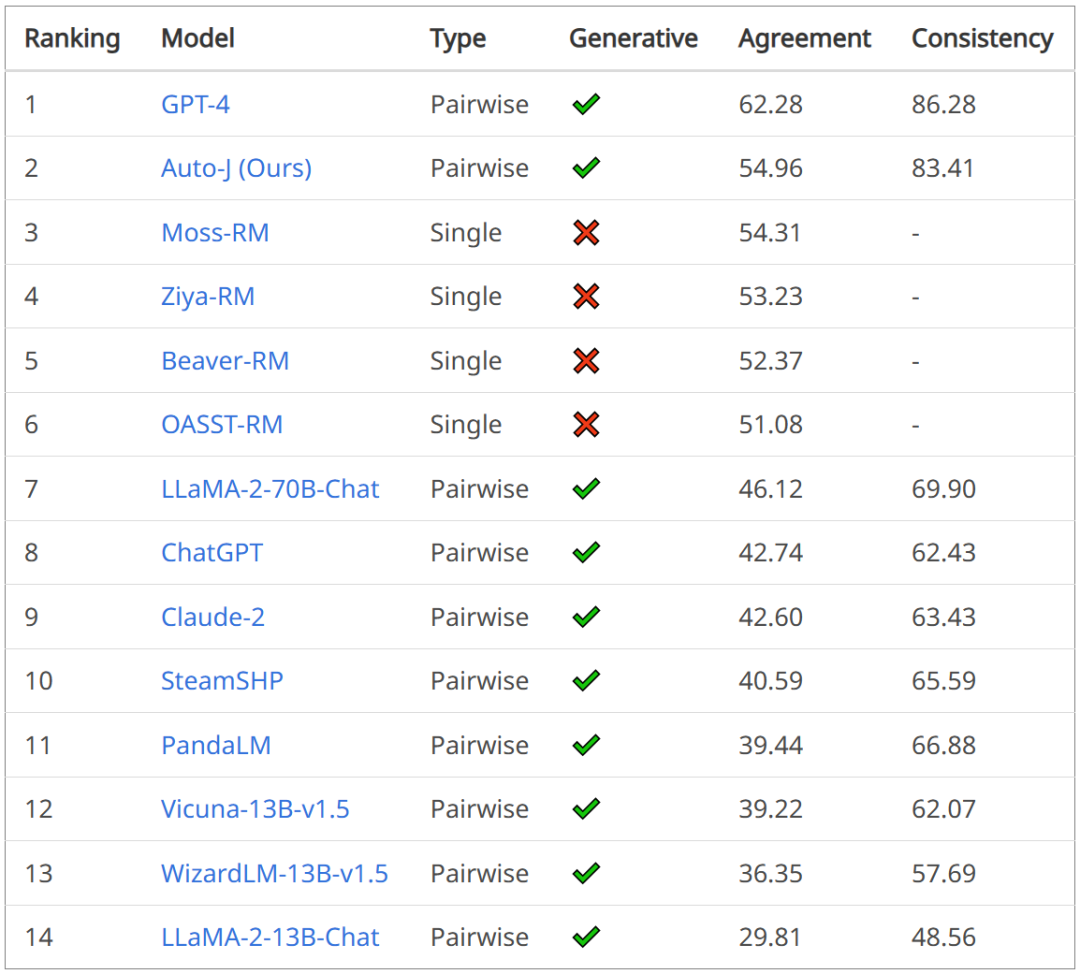

評論能力強於GPT-4,交開源13B評估大模型Auto-J

連結:https://news.miracleplus.com/share_link/11084

隨著生成式人工智慧技術的快速發展,確保大模型與人類價值(意圖)對齊(Alignment)已成為業界的重要挑戰。 雖然模型的對齊至關重要,但目前的評估方法往往存在局限性,這也讓開發者往往困惑:大模型對齊程度如何? 這不僅制約了對齊技術的進一步發展,也引發了公眾對技術可靠性的擔憂。 為此,上海交通大學生成式人工智慧實驗室迅速響應,推出了一款全新的價值對齊評估工具:Auto-J,旨在為業界和公眾提供更透明、準確的模型價值對齊評估。

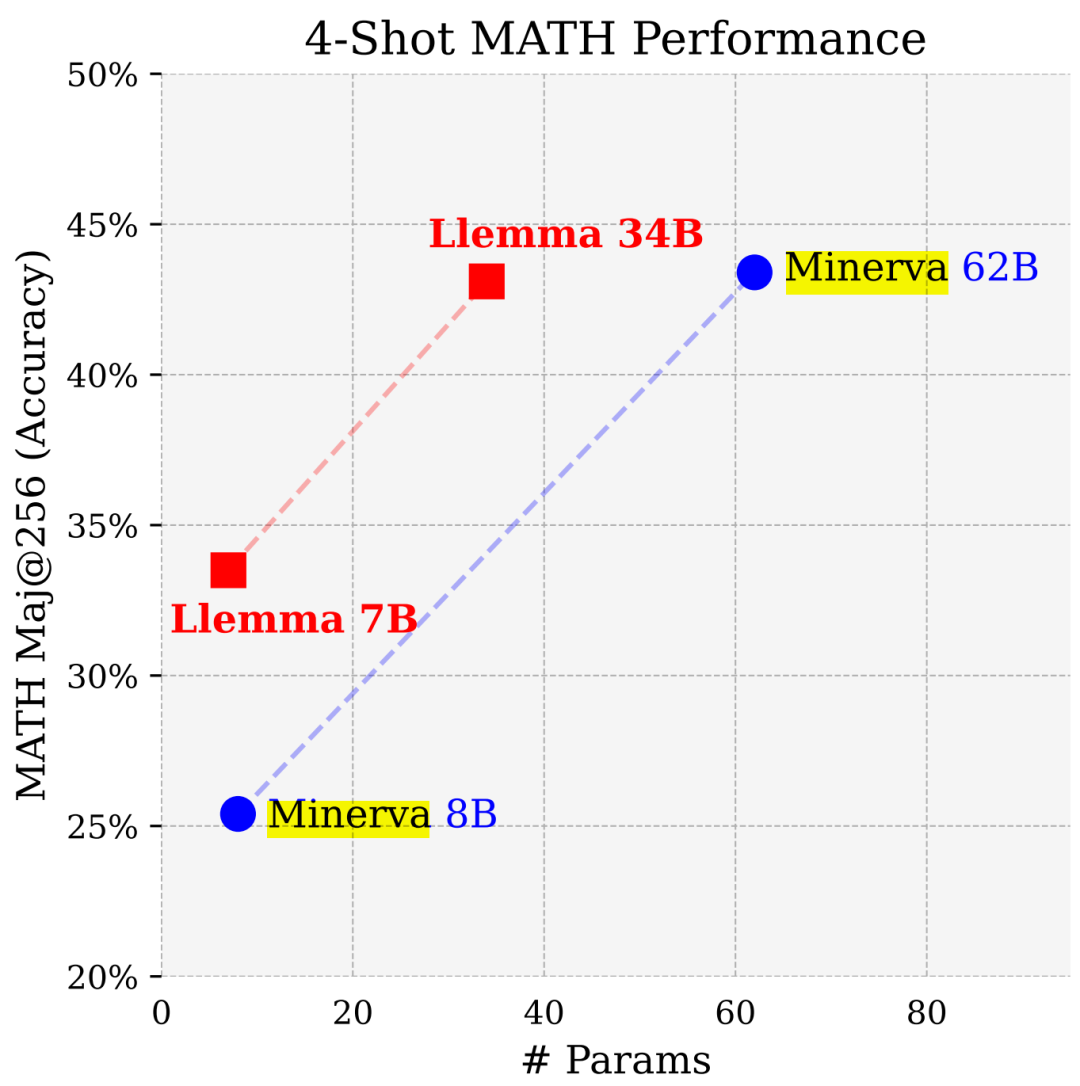

參數少近一半,效能逼近谷歌Minerva,又一個數學大模型開源了

連結:https://news.miracleplus.com/share_link/11085

普林斯頓大學、 EleutherAI 等的研究者為解決數學問題訓練了一個特定領域的語言模型。 他們認為:首先,解決數學問題需要與大量的專業先驗知識進行模式匹配,因此是進行領域適應性訓練的理想環境;其次,數學推理本身就是AI 的核心任務;最後,能夠進行強數學推理的 語言模型是許多研究主題的上游,如獎勵建模、推理強化學習和演算法推理。 因此,他們提出一種方法,透過對 Proof-Pile-2 進行持續的預訓練,使語言模型適應數學。 Proof-Pile-2 是數學相關文字和程式碼的混合資料。 將此方法應用於 Code Llama,可以得到 LLEMMA:7B 和 34B 的基礎語言模型,其數學能力得到了大幅提升。

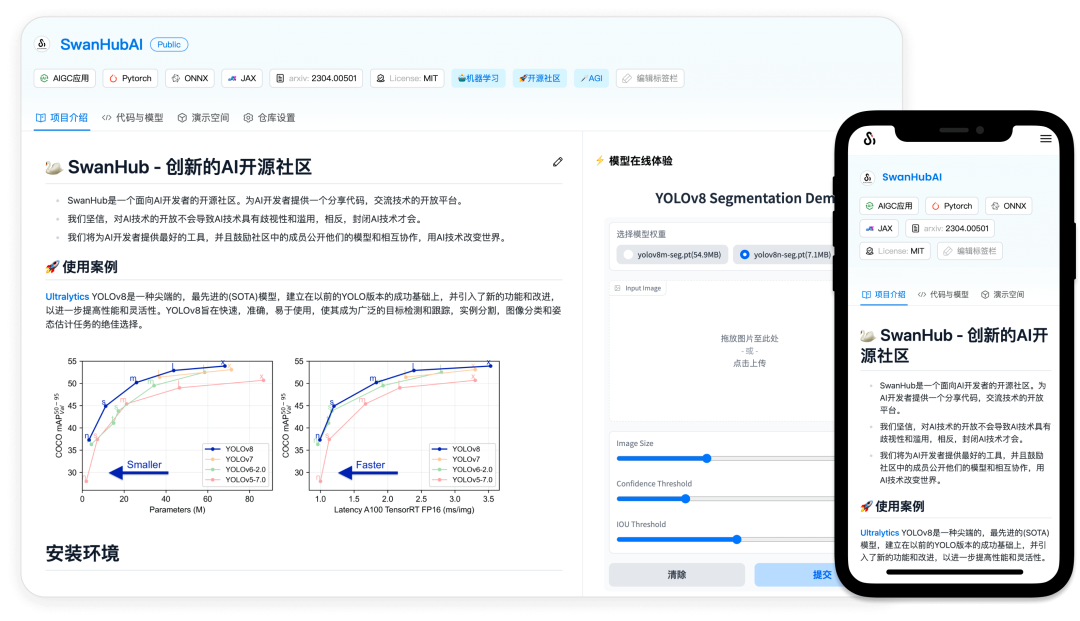

解決大模式復現難、協作難, 這支95後學生團隊打造了一個國產AI開源社群

連結:https://news.miracleplus.com/share_link/11086

大模型時代,如何建立一個方便的、能降低交流和協作門檻的平台已經成為一大挑戰。 我們所熟悉傳統的軟體開發協作方式,例如基於Git 的程式碼管理與版本控制,在A I 研發這種更依賴於實驗而非確定性過程的場景下可能不再適用,其複雜的實驗版本管理和較 高的使用、部署門檻往往阻礙了不同領域專家之間的溝通與協作。 目前的 AI 領域需要新的協作模式和工具,包括更直覺、易於使用的版本控制和協作平台,讓非技術背景的專家也能方便地參與模型的開發、評估和演示過程中。 換句話說,無論是科學研究工作者或從業者,都希望能在知識和技術的共享基礎上,實現更有效率、有深度的協作,推動 AI 領域的進一步發展。 在這樣的背景下,一個全新的 AI 開源社群平台「SwanHub」誕生了。

220億晶體管,IBM機器學習專用處理器NorthPole,能源效率25倍提升

連結:https://news.miracleplus.com/share_link/11087

隨著 AI 系統的快速發展,其能源需求也不斷增加。 訓練新系統需要大量的資料集和處理器時間,因此能耗極高。 在某些情況下,執行一些訓練好的系統,智慧型手機就能輕鬆勝任。 但是,執行的次數太多,能耗也會增加。 幸運的是,有許多方法可以降低後者的能耗。 IBM 和英特爾已經試驗過模仿實際神經元行為設計的處理器。 IBM 也測試了在相變記憶體中執行神經網路運算,以避免重複存取 RAM。 現在,IBM 又推出了另一種方法。 該公司的新型 NorthPole 處理器綜合了上述方法的一些理念,並將其與一種非常精簡的計算運行方法相結合,從而創造出一種能高效執行基於推理的神經網路的高能效晶片。 在影像分類或音訊轉錄等方面,該晶片的效率是 GPU 的 35 倍。

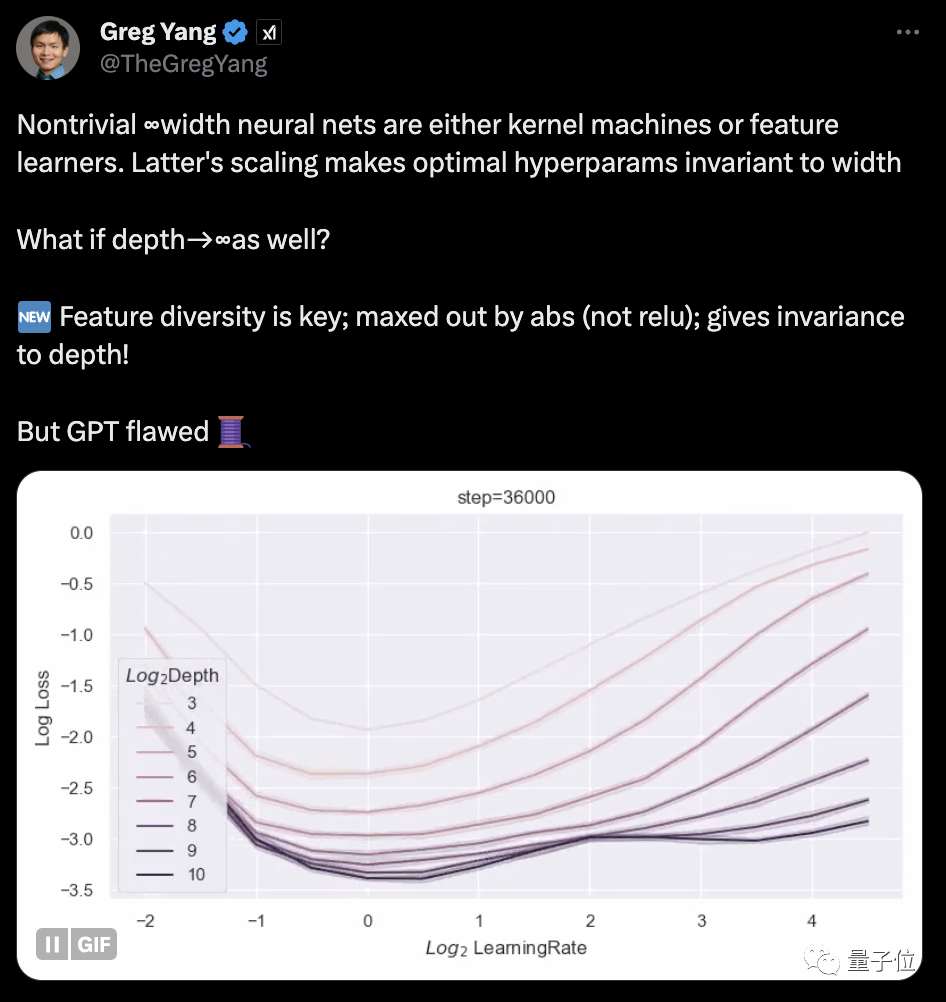

馬斯克xAI首個研究成果發布! 創始成員楊格&姚班校友共同一作

連結:https://news.miracleplus.com/share_link/11088

馬斯克的xAI,首項公開研究成果來了! 共同一作之一,正是xAI創始成員、丘成桐弟子楊格(Greg Yang)。 先前,楊格就曾公開表示,自己在xAI的研究方向是「Math for AI」和「AI for Math」。 其中一個重點就是延續他先前的研究:描述神經網路架構的統一程式語言Tensor Programs-相關成果,在GPT-4中已有應用。 這次的新論文,就歸屬該系列,重點探討了「如何訓練無限深度網路」。

LLaMA2上下文長度飆升至100萬tokens,只需調整1個超參數|復旦邱錫鵬團隊出品

連結:https://news.miracleplus.com/share_link/11089

只要微調一下,大模型支援上下文大小就能從1.6萬tokens延長至100萬? ! 還是在只有70億參數的LLaMA 2上。 要知道,即使是目前最火的Claude 2和GPT-4,支援上下文長度也不過10萬和3.2萬,超出這個範圍大模型就會開始胡言亂語、記不住東西。 現在,一項來自復旦大學和上海人工智慧實驗室的新研究,不僅找到了讓一系列大模型提升上下文視窗長度的方法,還發掘出了其中的規律。

一行程式碼提高大模型10%效能,開發者:免費午餐

連結:https://news.miracleplus.com/share_link/11090

大模型微調有「免費的午餐」了,只要一行程式碼就能讓效能提升至少10%。 在7B參數量的Llama 2上甚至出現了效能翻倍的結果,Mistral也有四分之一的成長。 雖然這種方法用在監督微調階段,但RLHF模型也能從中獲益。 來自馬裡蘭州大學、紐約大學等機構的研究人員提出了名為NEFT(une)的微調方式。 這是一種新的正則化技術,可用於提高微調監督(SFT)模型的效能。 這個方法已經被HuggingFace收錄進了TRL函式庫,只要import再加一行程式碼就能呼叫。 NEFT不僅操作簡便,而且沒有顯著的成本增加,作者稱看起來是個「免費的午餐」。

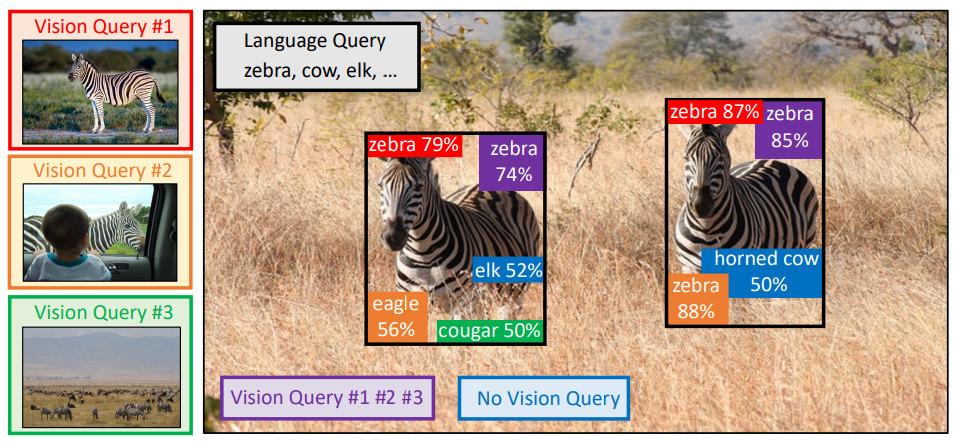

讓大模型看圖比打字管用! NeurIPS 2023新研究提出多模態查詢方法,準確率提升7.8%

連結:https://news.miracleplus.com/share_link/11091

大模型「識圖」能力都這麼強了,為什麼還老找錯東西? 例如,把長得不太像的蝙蝠和拍子搞混,又或是認不出一些資料集中的稀有魚類……這是因為,我們讓大模型「找東西」時,往往輸入的是文字。 如果描述有歧義或太偏門,像是「bat」(蝙蝠還是拍子?)或「魔鱂」(Cyprinodon diabolis),AI就會大為困惑。 這就導致用大模型做目標偵測、尤其是開放世界(未知場景)目標偵測任務時,效果往往沒有想像中那麼好。 現在,一篇被NeurIPS 2023收錄的論文,終於解決了這個問題。 論文提出了一個基於多模態查詢的目標偵測方法MQ-Det,只需為輸入加上一個圖片範例,就能讓大模型找東西的準確率大幅提升。 在基準檢測資料集LVIS上,無需下游任務模型微調,MQ-Det平均提升主流檢測大模型GLIP精度約7.8%,在13個基準小樣本下游任務上,平均提高了6.3%精度。