11月2日大模型日報合輯

【11月2日大模型日報合輯】黃仁勳:只要2年,英偉達甚至整個產業就會面目全非;矽仙人加持,Tenstorrent 能和英偉達扳手腕麼? 前 AMD 高層談晶片競爭與趨勢;Instagram版「Character.ai」要來了

黃仁勳:只要2年,英偉達甚至整個產業就會面目全非

連結:https://news.miracleplus.com/share_link/11378

黃仁勳對未來做出預言:運算技術將每十年進步一百萬倍,只要2年,英偉達甚至整個產業就會面目全非。 其判斷依據,60年來首次看到兩項技術轉型同時發生:AI與計算。 此言出自老黃最新訪談,與惠普公司The Moment節目主持人Ryan Patel的對談。 在節目上,老黃還透露了一件令人吃驚的事:一直穿皮衣,居然不是他自己的主意。 從2013年起,皮衣幾乎與老黃的形象綁在一起,連他在Reddit論壇的自我介紹都是「英偉達CEO,那個穿著皮衣,把話重複三次的人」。

矽仙人加持,Tenstorrent 能和英偉達扳手腕麼? 前 AMD 高層談晶片競爭與趨勢

連結:https://news.miracleplus.com/share_link/11379

David Bennett 曾是AMD 以及聯想的高管,目前擔任Tenstorrent 的COO(首席客戶官),在最新的外媒採訪中,Bennett認為,未來的晶片將結合GPU 和CPU,以更快地準備和加載數據 ,從而加速模型訓練的過程,這一點我們從3 年前的蘋果M 系列發布就能看出。 談到蘋果,6 月也曾分享過矽仙人Jim Keller 作為Tenstorrent CEO 發表的關於AI 晶片與市場競爭洞察,Keller 是一位硬體傳奇人物,曾開發Apple 的A4 和A5 處理器,並在2016~2018 年參與了Tesla 的自動駕駛硬體工作。 目前,Tenstorrent已從投資者那裡籌集了超過3億美元,包括 Fidelity Ventures 和 Hyundai Motor Group,目前正按照Bennett的建議進行運作,提供的服務覆蓋自家的晶片以及雲端服務。

GPT-4能「偽裝」成人類嗎? 圖靈測試結果出爐

連結:https://news.miracleplus.com/share_link/11380

為了解答這個問題,圖靈設計了一個能間接提供答案的模仿遊戲。 遊戲的最初設計涉及兩位見證者(witness)和一位審問者(interrogator)。 兩位見證者一個是人類,另一個是人工智慧;他們的目標是透過一個純文字的互動介面說服審問者相信他們是人類。 這個遊戲本質上是開放性的,因為審問者可以提出任何問題,不管是關於浪漫愛情,抑或是數學問題。 圖靈認為這一性質能夠對機器的智慧進行廣泛的測試。 後來這個遊戲被稱為圖靈測試(Turing Test),但人們也在不斷爭論這項測試究竟測算的是什麼以及哪些系統有能力通過它。 以 GPT-4 為代表的大型語言模型(LLM)簡直就像是專為圖靈測驗而生的! 它們能產生流暢自然的文本,並且在許多語言相關的任務上都已達到比肩人類的水平。 實際上,已經有不少人在猜測 GPT-4 也許能夠通過圖靈測試了。 近日,加州大學聖迭戈分校的研究者 Cameron Jones 和 Benjamin Bergen 發布了一份研究報告,給出了他們對 GPT-4 等 AI 智能體進行圖靈測試的實證研究結果。

GPT-4變笨加劇,被爆緩存歷史回覆:笑話講八百遍,讓換新的也不聽

連結:https://news.miracleplus.com/share_link/11381

有網友找到了GPT-4變成「笨」的另一個證據。 他質疑:OpenAI會快取歷史回复,讓GPT-4直接複述先前產生過的答案。 最明顯的例子就是講笑話。 證據顯示,即使他將模型的temperature值調高,GPT-4仍重複同一個「科學家與原子」的答案。 就是那個「為什麼科學家不信任原子?因為萬物都是由它們編造/構造(make up)出來的」的冷笑話。 在此,照理說temperature值越大,模型越容易產生一些意想不到的詞,不該重複同一個笑話了。 不止如此,即使咱們不動參數,換個措辭,強調讓它講一個新的、不同的笑話,也無濟於事。

小冰CEO李笛:大模型商業化像掃雷 | REAL科技大會

連結:https://news.miracleplus.com/share_link/11382

小冰公司CEO李笛:大模型商業化像「掃雷」的過程;智源研究院副院長林詠華:從業者需要打造像「大模型的Linux」的開源生態;百川智慧CEO王小川: 智力不是邏輯推理,而是一種抽象和比喻的能力;人工智慧將帶來一場「逆工業革命」;優秀的程式設計師,甘願被AI取代…這是第三屆REAL科技大會上嘉賓的 精彩發言,除此之外,共有20餘位嘉賓圍繞著人工智慧等熱門科技話題發表了觀點。 這些嘉賓中既有創業者也有投資者,還有技術人員和高校學者,他們從不同角度談論了人工智慧的發展。

用FP8訓練大模型有多香? 微軟:比BF16快64%,省42%內存

連結:https://news.miracleplus.com/share_link/11383

大型語言模型(LLM)具有前所未有的語言理解和生成能力,但是解鎖這些高級的能力需要龐大的模型規模和訓練計算量。 在這種背景下,尤其是當我們專注於擴展至OpenAI 提出的超級智慧(Super Intelligence) 模型規模時,低精度訓練是其中最有效且最關鍵的技術之一,其優點包括記憶體佔用小、訓練速度 快,通訊開銷低。 目前大多數訓練框架(如 Megatron-LM、MetaSeq 和 Colossal-AI)訓練 LLM 預設使用 FP32 全精度或 FP16/BF16 混合精度。 但這仍然沒有推至極限:隨著英偉達 H100 GPU 的發布,FP8 正在成為下一代低精度表徵的資料類型。 理論上,相較於目前的 FP16/BF16 浮點混合精度訓練,FP8 能帶來 2 倍的速度提升,節省 50% – 75% 的記憶體成本和 50% – 75% 的通訊成本。 儘管如此,目前對 FP8 訓練的支援仍很有限。 英偉達的 Transformer Engine (TE),只將 FP8 用於 GEMM 計算,其所帶來的端對端加速、記憶體和通訊成本節省優勢就非常有限了。 但現在微軟開源的FP8-LM FP8 混合精度框架大大解決了這個問題:FP8-LM 框架經過高度優化,在訓練前向和後向傳遞中全程使用FP8 格式,大大降低了系統的計算,顯存 和通訊開銷。

支援二次編輯、導入虛擬引擎5,Stable Diffusion進化出3D生成功能

連結:https://news.miracleplus.com/share_link/11384

說到文生圖大模型,Stability AI 在 2022 年推出的 Stable Diffusion 可謂是其中的翹楚,不斷為富有創意的故事講述者提供他們所需要的 AI 工具。 不過,該模型主要用於 2D 影像生成。 今天,Stability AI 向我們展示了更多影像增強功能,產生了更美觀的影像、同時也更便宜、速度更快。 更重要的是,現在有了可以搞定任何類型 3D 內容創建的新工具了。

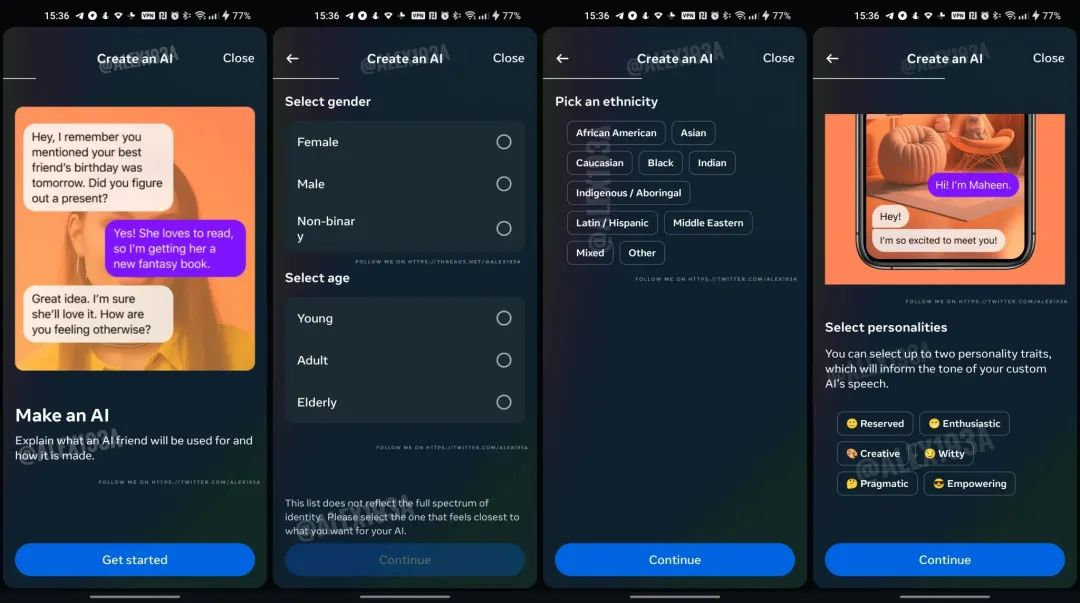

Instagram版「Character.ai」要來了

連結:https://news.miracleplus.com/share_link/11385

上個月,Meta 推出了 28 款可在 Instagram、Messenger 和 WhatsApp 上與用戶聊天的 AI 聊天機器人,其中一些聊天機器人由 Kendall Jenner、Snoop Dogg、Tom Brady 和 Naomi Osaka 等知名人士扮演。 近日,根據海外研究人員Alessandro Paluzzi 分享的截圖顯示,Instagram 正在開發名為「AI Friend」的功能,用戶可以根據自己的喜好自訂AI 朋友,然後與其進行對話;用戶可以向AI 朋友提問,探討挑戰 ,腦力激盪想法等等。