11 月 2 日の Big Model Daily コレクション

[11 月 2 日の Big Model Daily コレクション] Jen-Hsun Huang: わずか 2 年で、NVIDIA、さらには業界全体が完全に変わってしまうでしょう; シリコン不滅の祝福により、Tenstorrent は NVIDIA と競争できるでしょうか? 元AMD幹部がチップ競争とトレンドを語る、インスタグラム版「Character.ai」登場

Huang Renxun: わずか 2 年で、NVIDIA、さらには業界全体が完全に変わってしまうでしょう。

リンク: https://news.miracleplus.com/share_link/11378

Huang Renxun 氏は、「コンピューティング テクノロジーは 10 年ごとに 100 万倍も進歩し、わずか 2 年で、NVIDIA だけでなく業界全体も完全に変わってしまうでしょう」と未来予測を立てました。 この判断の根拠は、この 60 年間で初めて、AI とコンピューティングという 2 つの技術変革が同時に起こっているということです。 この声明は、HP の The Moment プログラムの司会者である Ryan Patel との Lao Huang の最新インタビューから出たものです。 番組では、黄さんは驚くべきことも明らかにした。革製の服を常に着ることは彼自身の考えではなかったという。 2013年以降、革服はファン氏のイメージとほぼ結びついており、Redditフォーラムでの彼の自己紹介も「革服を着て言葉を三度繰り返す男、NVIDIA CEO」となっている。

Silicon Immortal の恩恵を受けて、Tenstorrent は Nvidia と競争できるでしょうか? 元AMD幹部がチップの競争とトレンドについて語る

リンク: https://news.miracleplus.com/share_link/11379

デビッド・ベネット氏は元AMDとレノボの幹部で、現在はTenstorrentのCOO(最高顧客責任者)を務めているが、最新の海外メディアのインタビューでベネット氏は、将来のチップはGPUとCPUを組み合わせてデータの準備とロードをより速く行うことで、データの準備とロードを高速化すると信じていると述べた。モデルのトレーニング プロセスは、3 年前の Apple の M シリーズのリリースから見ることができます。 Apple といえば、6 月に Tenstorrent の CEO として AI チップと市場競争に関するシリコン不滅のジム・ケラー氏の洞察も共有しました. ケラー氏は、Apple の A4 および A5 プロセッサを開発し、2016 年から 2018 年にかけてそれらに取り組んだハードウェアの伝説的人物です。テスラの自動運転ハードウェアの仕事で。 TenstorrentはFidelity VenturesやHyundai Motor Groupなどの投資家から3億ドル以上を調達しており、現在はベネット氏の推奨に従って運営しており、自社チップとクラウドサービスをカバーするサービスを提供している。

GPT-4は人間に「変装」できるのでしょうか? チューリングテストの結果が発表されました

リンク: https://news.miracleplus.com/share_link/11380

この質問に答えるために、チューリングは間接的に答えを提供する模倣ゲームを設計しました。 ゲームの当初の設計では、2 人の証人と 1 人の尋問者が関与していました。 2 人の証人、1 人は人間、もう 1 人は人工知能であり、テキストのみの対話型インターフェイスを通じて尋問者に自分たちが人間であることを納得させることを目的としています。 質問者は恋愛に関するものでも数学に関するものでも、どんな質問でもできるため、このゲームは本質的に自由です。 チューリングは、この特性が機械知能の広範なテストを提供できると信じていました。 このゲームは後にチューリング テストとして知られるようになりましたが、テストで正確に何を測定するのか、どのシステムがそれに合格できるのかについては議論が続いています。 GPT-4 に代表される大規模言語モデル (LLM) は、チューリング テスト用に単純に設計されています。 スムーズで自然なテキストを生成でき、多くの言語関連タスクで人間レベルのパフォーマンスに達しています。 実際、多くの人がすでに GPT-4 がチューリング テストに合格できるのではないかと推測しています。 最近、カリフォルニア大学サンディエゴ校の研究者であるキャメロン・ジョーンズとベンジャミン・バーゲンは、GPT-4などのAIエージェントのチューリングテストに関する実証研究の結果を示す研究報告書を発表した。

GPT-4はどんどんバカになってきて、キャッシュ履歴も暴露された 返信: 冗談を800回言っても、変更しても聞く耳を持ちません。

リンク: https://news.miracleplus.com/share_link/11381

一部のネチズンは、GPT-4が「愚か」になったことを示す別の証拠を発見した。 同氏は疑問を呈した。OpenAI は履歴応答をキャッシュし、GPT-4 が以前に生成した応答を直接再現できるようにする。 最もわかりやすい例はジョークを言うことです。 証拠は、彼がモデルの温度値をより高く調整したときでも、GPT-4 は依然として同じ「科学者と原子」の答えを繰り返したことを示しています。 それは、「なぜ科学者は原子を信じないのですか?すべては原子でできているからです。」という冷たいジョークです。 ここで、温度値が大きいほど、モデルが予期しない単語を生成しやすくなるのは当然であり、同じジョークを繰り返すべきではありません。 それ以上に、パラメーターを変更せず、表現を変更し、新しくて異なるジョークを伝えていることを強調したとしても、役に立ちません。

Xiaobing CEO Li Di: 大型モデルの商品化は掃海艇のようなもの | REAL Technology Conference

リンク: https://news.miracleplus.com/share_link/11382

Xiaobing CEO Li Di: 大型モデルの商用化は「掃海」プロセスのようなものです; Zhiyuan Research Institute 副所長の Lin Yonghua: 実務家は「大型モデル用 Linux」のようなオープンソース エコシステムを構築する必要があります; Baichuan Intelligence CEO の Wang Xiaochuan 氏: インテリジェンスとは論理的推論ではなく、抽象化と比喩の能力である; 人工知能は「反産業革命」をもたらす; 優秀なプログラマーはAIに取って代わられることをいとわない… 第3回リアルテクノロジーのゲストスピーチですカンファレンス 素晴らしいスピーチに加えて、20 人以上のゲストが人工知能などの注目の技術トピックについて意見を表明しました。 起業家、投資家、技術者、大学の学者などがゲストとして参加し、人工知能の開発についてさまざまな視点から語りました。

FP8 を使用して大規模なモデルをトレーニングするのはどれほど楽しいでしょうか? Microsoft: BF16 より 64% 高速、メモリを 42% 節約

リンク: https://news.miracleplus.com/share_link/11383

大規模言語モデル (LLM) は、前例のない言語理解および生成機能を備えていますが、これらの高度な機能を解放するには、膨大なモデル規模とトレーニング計算が必要です。 これに関連して、特に OpenAI が提案するスーパー インテリジェンス モデルのスケールに合わせてスケーリングすることに焦点を当てた場合、低精度トレーニングは最も効果的かつ重要な手法の 1 つです。その利点には、小さいメモリ フットプリント、トレーニング速度、高速かつ低い通信オーバーヘッドが含まれます。 。 現在、ほとんどのトレーニング フレームワーク (Megatron-LM、MetaSeq、Colossal-AI など) は、デフォルトで FP32 完全精度または FP16/BF16 混合精度を使用して LLM をトレーニングします。 しかし、それでも限界を超えているわけではありません。Nvidia の H100 GPU のリリースにより、FP8 は次世代の低精度表現データ型になりつつあります。 理論的には、現在の FP16/BF16 浮動小数点混合精度トレーニングと比較して、FP8 は 2 倍の速度向上をもたらし、メモリ コストの 50% ~ 75% と通信コストの 50% ~ 75% を節約できます。 それにもかかわらず、FP8 トレーニングのサポートは現在限定されています。 NVIDIA の Transformer Engine (TE) は GEMM 計算に FP8 のみを使用するため、エンドツーエンドの高速化、メモリ、通信コストの節約は非常に限られています。 しかし現在、Microsoft のオープンソース FP8-LM FP8 混合精度フレームワークによって、この問題が大幅に解決されました。FP8-LM フレームワークは高度に最適化されており、トレーニングの前方および後方パス全体で FP8 形式を使用するため、システムの計算とメモリが大幅に削減されます。通信のオーバーヘッド。

Virtual Engine 5の二次編集・インポートに対応、Stable Diffusionで3D生成機能が進化

リンク: https://news.miracleplus.com/share_link/11384

大規模モデルに関しては、2022 年に開始された Stability AI の Stable Diffusion がリーダーであり、クリエイティブなストーリーテラーに必要な AI ツールを提供し続けています。 ただし、このモデルは主に 2D 画像生成に使用されます。 現在、Stability AI はより多くの画像補正機能を提供し、より安価で高速に見栄えの良い画像を生成します。 さらに、あらゆるタイプの 3D コンテンツ作成を処理できる新しいツールが登場しました。

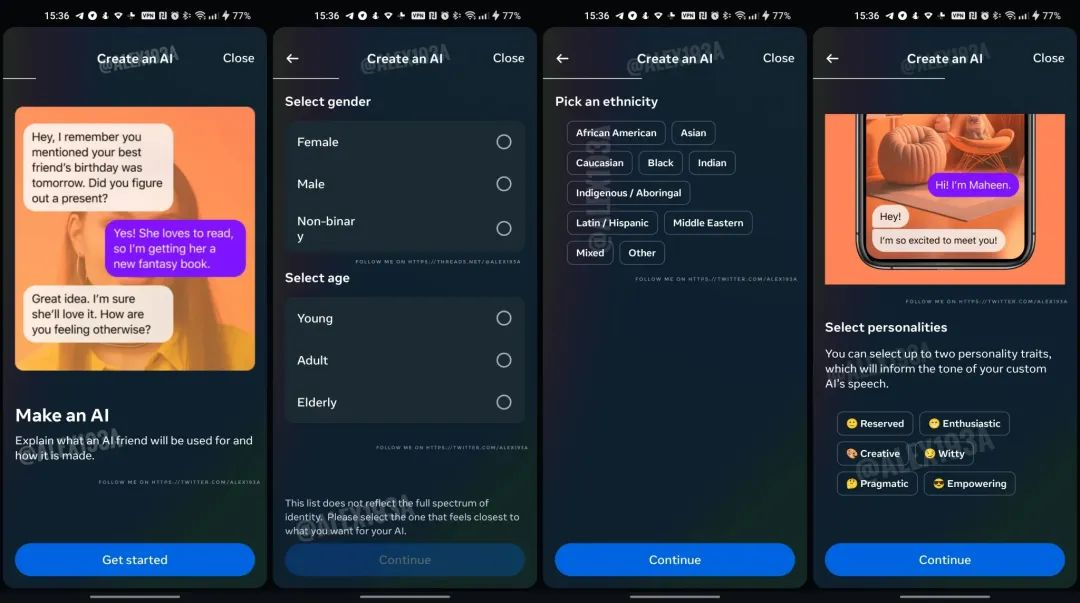

Instagram版「Character.ai」登場

リンク: https://news.miracleplus.com/share_link/11385

メタは先月、インスタグラム、メッセンジャー、ワッツアップでユーザーとチャットできる28種類のAIチャットボットを立ち上げ、その一部はケンダル・ジェンナー、スヌープ・ドッグ、トム・ブレイディ、大坂なおみといった有名人が演じている。 最近、海外研究者のアレッサンドロ・パルッツィ氏が共有したスクリーンショットによると、インスタグラムは「AIフレンド」と呼ばれる機能を開発中で、ユーザーはAIフレンドを自分の好みに合わせてカスタマイズして会話したり、AIフレンドに質問したり課題について話し合ったりできるという。 、アイデアのブレインストーミングなど。